Suomen Campaign to Stop Killer Robots verkosto järjesti 10.11.20 webinaarin, jossa keskusteltiin tappajarobottien herättämistä eettisistä huolenaiheista tekoälykehittäjien haasteiden, vastuun ja algoritmisen syrjinnän näkökulmista. Osallistujia oli maksimimäärä, mikä kertoo, että aihe on paitsi kiinnostava, myös ajankohtainen ja akuutti.

Mitä huolenaiheita herää, kun päätös tappavan voiman käytöstä siirretään ihmiseltä koneelle?

Tekoälyn vaikutukset yhteiskuntiimme nousevat yhä useammin esille julkisessa keskustelussa. Vähemmälle huomiolle jäävät samaa teknologian kehitystä hyödyntävät täysin autonomiset asejärjestelmät – tuttavallisemmin robottiaseet tai tappajarobotit, arvioi Suomen kampanjaverkoston koordinaattori Kaisu Kinnunen. Kun robotti saa valita kohteensa ja iskeä siihen itsenäisesti ilman ihmisen väliintuloa, nousee esille monia eettisiä ongelmakohtia. Hakkerointi, vikatilanteet, vinoumat ja ennakoimattomuus sekä epäinhimillinen sodankäynti ovat uhkia, jotka tulee ottaa vakavasti.

Campaign to Stop Killer Robots -kampanjan tarkoituksena on varmistaa, että autonomiset asejärjestelmät kielletään ennen kuin niiden kehittäminen ja käyttäminen yleistyvät. Tällä tavoin voidaan estää kylmän sodan kaltainen kilpavarustelu, joka ylittää sodankäynnin viimeisetkin moraaliset rajat.

Kukaan ei voi ennustaa, minkälaisiin seurauksiin autonomisten asejärjestelmien käyttöönotto sodassa johtaisi, sillä robottiaseiden testaaminen käytännössä ennen itse taistelutilannetta on haastavaa. Koe-eläimiksi joutuisi nimenomaan itse ihmiskunta, koska sotaa käydään siellä, missä ihmisetkin ovat. On epätodennäköistä, että autonomisten asejärjestelmien mahdolliset edut ylittäisivät varmat haitat ja riskit.

“Haluammeko testata teknologian toimivuutta ihmisiin, kun kyse on tappavaa voimaa käyttävästä asejärjestelmästä, joka voi olla vaikea pysäyttää sen jälkeen kun se on otettu käyttöön?”

Kaisu Kinnunen

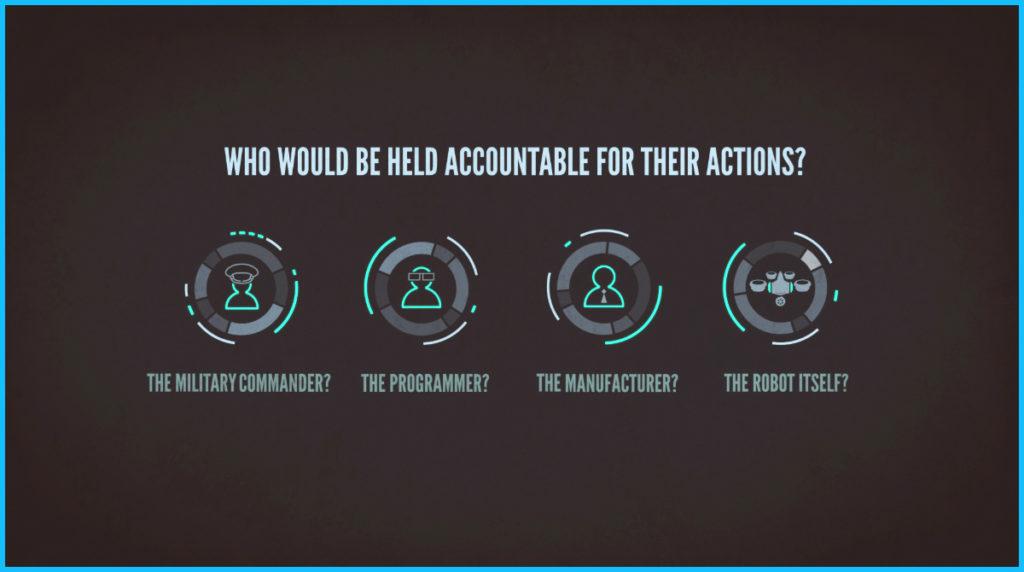

Robottiaseet herättävät myös merkittäviä vastuuseen liittyviä kysymyksiä: jos konetta ei voi pitää vastuussa mahdollisista sotarikoksista, kenen vastuulla vääryydet sitten ovat? Joutuuko sotatuomioistuimen eteen asejärjestelmän kehittäjä, valmistaja vai tappajarobottia käyttäneen armeijan komentaja?

Teknologian kehittäminen ja ammattieettinen vastuu kulkevat käsi kädessä

Vastuukysymykset eivät liity yksin sotateollisuuteen. Tekoälyjärjestelmiä omiin tarkoituksiinsa kehittävät teknologiayritykset joutuvat myös ottamaan kantaa vaikeisiin kysymyksiin: Miten voidaan varmistaa, ettei kehitettyä teknologiaa sovelleta epäeettisiin tarkoituksiin jonkin toisen yrityksen toimesta? Entä onko järkeä jättää kehittämättä potentiaalisesti vaarallinen tekoälyjärjestelmä, jos joku toinen yritys kuitenkin tulee kehittämään samanlaisen järjestelmän ennemmin tai myöhemmin?

Tekoälyn yleistä kehitystä ei voi selkeästi erottaa robottiaseisiin linkittyvästä kehityksestä. Sovellusalueita on useita aina kasvojentunnistuksesta itse ajaviin ajoneuvoihin, ja siksi rajanveto on hyvin haastavaa.

Tekoälykehittäjien vastuukysymyksiä tutkiva väitöskirjatutkija Juho Vaiste muistuttaa, että avoimuus tekoälyn käyttötarkoituksista ei ole sama asia kuin läpinäkyvyys. Harva tulee edes ajatelleeksi, että myös erilaisten sovellusten käyttäjät saattavat edistää epäsuorasti robottiaseiden kehittämistä esimerkiksi kännykkänsä puheentunnistusta käyttämällä – tämä kun edesauttaa, että tunnistusteknologia kehittyy entistä tarkemmaksi.

“Tekoälykehittäjillä on ammattieettinen vastuu toimia oikein, vaikka lopullista vastuuta kehitetyn teknologian käytöstä ei olisikaan.”

Juho Vaiste

Vaiste korostaa, että vastuun jakamisessa on tärkeää erottaa toisistaan käsitteet vastuuvelvollisuus (accountability) ja vastuu (responsibility). Vastuuvelvollisuuden palauttaminen tietylle kehittäjälle on vaikeaa, mutta tämä ei poista moraalista ja ammattieettistä vastuuta siitä, mihin kehitettyä teknologiaa käytetään. Pääkysymys onkin, onko tekoälyn kehittäjillä valmiuksia ottaa kantaa robottiaseisiin liittyviin elämän ja kuoleman kysymyksiin.

Loppujen lopuksi ei ole aina yksinkertaista erottaa, millainen tekoälyn kehityskulku tulee vastaisuudessa hyödyttämään ihmiskuntaa tai mitä kehityssuuntia voidaan pitää arveluttavina ihmisoikeuksien kannalta.

Läpinäkyvyys ja yhdenvertaisuus luovat haasteita autonomisille asejärjestelmille

Automatisoituun päätöksentekoon ja algoritmiseen syrjintään perehtynyt filosofian väitöskirjatutkija Otto Sahlgren kertoo, että tekoälystä puhuttaessa puhutaan useimmiten automatisoidusta tilastollisesta analyysista ja päätöksenteosta. Tekoälyalgoritmit ”koulutetaan” näyttämällä niille harjoitusesimerkkejä, joiden pohjalta algoritmi oppii, mitä päätöksiä sen tulee tehdä. Tekoäly on siis algoritmin ja sen hyödyntämän datan yhteisvaikutus.

Tekoälyä hyödyntävät järjestelmät – esimerkiksi autonomiset asejärjestelmät – eivät ole siinä mielessä älykkäitä, että ne kykenisivät tulkitsemaan ympärillä vallitsevaa sosiaalista tilannetta tai käymään eettisiä pohdintoja. Ne ainoastaan uusintavat oppimaansa, mikä voi käytännössä tarkoittaa syrjinnän loputonta toisintamista. Tällaiset algoritmiset vinoumat (algorithmic bias) voivat olla esimerkiksi kehnon mallintamisen ja epäedustavan datan tulosta. Ne saattavat osaltaan heijastaa yhteiskunnassa vallitsevaa rakenteellista epätasa-arvoa.

“Yhdysvaltojen tuomioistuimissa rikoksen uusimisen riskiä ennustavan järjestelmän todettiin pitävän tummaihoisia herkemmin syyttä tutkintavankeudessa, kun taas valkoihoisia rikoksenuusijoita päästettiin herkemmin vapaaksi.”

Otto Sahlgren

Läpinäkyvyyden puute tekoälyn kehittämisessä on suuri ongelma sekä tekniseltä että institutionaaliselta kannalta: Ensinnäkin on haastava ymmärtää ja selittää, millä logiikalla tekoälyjärjestelmä tekee päätöksensä. Lisäksi algoritmit ja niiden kehityshistoria pidetään usein salassa. Tämä tarkoittaa, ettei niiden taustalla vaikuttavia periaatteita pystytä arvioimaan. Koska on vaikea päätellä, millä datalla autonomisten asejärjestelmien algoritmeja opetetaan ja testataan, on myös vaikea sanoa, missä määrin algoritminen syrjintä tulee näkymään robottiaseiden toiminnassa.

On epätodennäköistä, että tappajarobottien algoritmit kykenisivät ottamaan huomioon sen ominaisuuksien yhteissumman, jonka perusteella voi päätellä, onko asejärjestelmän kohde oikea vai väärä. Lisäksi tekoälyjärjestelmät ovat alttiita hämäyksille ja hakkeroinnille: esimerkiksi algoritmeille voidaan syöttää kohinalla kyllästettyä dataa niin, että ne eivät enää kykene luotettavasti tulkitsemaan ympäristöään.

“Kone on kyvytön ymmärtämään kontekstia, mikä on kriittistä kohteen valinnassa ja sodan sääntöjen seuraamisessa. Autonominen ase ei ole vapaa ennakkoluuloista, joita sen opettamiseen käytetty data voi ilmentää.”

Kaisu Kinnunen

Tekoälyä koskevissa eettisissä ohjeistuksissa useimmin esiintyviä periaatteita ovat läpinäkyvyys, oikeudenmukaisuus, vaarattomuus ja vastuullisuus. Periaatteet kuten ihmisarvo ja solidaarisuus puolestaan esiintyvät harvimmin. Valitettavasti juuri näitä vähimmissä määrin huomioituja periaatteita voidaan pitää kaikista vahvimpina argumentteina.

Sahlgren painottaa, että selitettävyyteen, vinoumiin ja muihin tekniikan ongelmiin vetoavat vastalauseet autonomisille asejärjestelmille eivät riitä. Tekniikan ongelmiin voidaan löytää kapeita, teknisiä ratkaisuja. Pahimmillaan päädymme luomaan kysyntää tällaiselle teknologialle ja sen kehitykselle. Näiden perusteluiden sijasta pitäisikin keskittyä soveltamaan globaalin demokratian, rauhan ja solidaarisuuden ihanteita myös tekniikkaan liittyvissä ideologisissa kysymyksissä.

“Etiikka on dialogista, se on ihmisten toimintaa. Etiikka ei ole pelkistettävissä väittämiin tai ohjeisiin, jotka voisi vain koodata järjestelmään ja tehdä koneesta eettisen.”

Otto Sahlgren

Tärpit webinaarista:

- Läpinäkyvyyden ja ammattietiikan kulttuurit eivät (ainakaan vielä) korostu tekoälyn kehittäjien joukossa tarpeeksi. Silti teknologian ja tekoälyn etiikkaa tulisi käsitellä yhtä tärkeänä etiikan osa-alueena kuin muitakin soveltavan etiikan haaroja.

- Tarvitaan tekoälykehitykseen liittyvää, sotateollisuutta rajoittavaa lainsäädäntöä, sekä säädöksiä, joilla painostaa isoja teknologiayrityksiä oikeaan kehityssuuntaan huolimatta siitä, onko niillä suoraa asiakassuhdetta sotateollisuuden toimijoihin vai ei.

- Autonomisuuden aste tekoälyjärjestelmissä vaihtelee, mikä tekee niihin suhtautumisesta haastavampaa. Jotta ”monen tekijän ongelmaan” voidaan ottaa kantaa, niin robottiaseiden kehittäjien, omistajien ja käyttäjien kuin suuren yleisönkin tulisi ymmärtää tekoälyjärjestelmien toimintaperiaatteet.

- Tekoälyn kehittäjillä on oikeus tietää ja määritellä, mihin heidän työpanostaan käytetään.

- Kaikkein vahvimmat argumentit autonomisia asejärjestelmiä vastaan eivät liity itse tekniikkaan ja sen kehitykseen, vaan ihmisarvoon ja solidaarisuuteen.

Tilaisuus oli ensimmäinen yliopistoille suunnatussa webinaarisarjassamme. Jos haluat mukaan toimintaan tai sinulla on idea webinaarin seuraaville osioille, voit olla suoraan yhteydessä Kaisuun: kaisu.kinnunen@sadankomitea.fi.

Tiedotamme Suomen verkoston toiminnasta ja tulevista tapahtumista myös Facebookissa @stopkillerrobotFI ja Twitterissä @KillerRobotsFI.

Kirjoittaja on kampanjan aktiivi Riikka Aarnos, joka toimi myös webinaarin juontajana.

Tilaisuudessa Sadankomitean puheenjohtaja ja Campaign to Stop Killer Robots Suomen verkoston koordinaattori Kaisu Kinnunen esitteli täysin autonomisten asejärjestelmien herättämiä eettisiä ja turvallisuuteen liittyviä kysymyksiä aseidenriisunnan ja rauhantyön näkökulmista.

Tekoälyn etiikan teemoista erityisesti tekoälykehittäjien vastuun ja eettisen toimijuuden näkökulmasta puhui väitöskirjatutkija Juho Vaiste Turun yliopistosta.

Filosofian väitöskirjatutkija Otto Sahlgren Tampereen yliopistosta käsitteli tekoälyn etiikkaa, yhdenvertaisuutta, syrjintää ja reiluutta algoritmisen päätöksenteon kontekstissa.